|

Comment

connaître ou reconstruire l´histoire de l’Univers ? Les objets dont

il est constitué, sa composition chimique ou les rayonnements qui le

parcourent sont autant d’indices, car plus on regarde loin plus on

s’éloigne dans le passé… Un voyage qui nous révèle l’Univers tel

qu’il était au début de son expansion.

On peut observer ainsi avec une grande

précision le rayonnement du Fond Diffus Micro-ondes (abrégé en

anglais par CMB) à l’aide d’expériences emportées par des ballons

stratosphériques ou des satellites,

Planck par

exemple ou encore le satellite COBE, qui a valu à son concepteur,

George F. Smoot, le prix Nobel de physique en 2006. Ce rayonnement

du fond de l’Univers nous est familier car il représente quelques

pourcents du signal que l´on aperçoit sur un poste de télévision

réglé hors fréquences des canaux usuels. Pour le cosmologiste, ce

rayonnement est un outil précieux car il représente avant tout un

fossile des premières phases de

l’expansion universelle. Mais entre le moment où ce

rayonnement a été émis (environ 400 000 ans après le big-bang) et

aujourd’hui, notre connaissance de l’histoire de l’Univers reste

très lacunaire. Que s’est-il passé depuis et comment le savoir ?

On pourrait en principe reconstruire par la pensée son

évolution, en s’appuyant sur les conditions initiales fournies par

notre connaissance du fond diffus cosmologique. Mais l´Univers est

si vaste et il y a tellement de paramètres à considérer, qu’il nous

faut parfois aussi concéder une partie du travail à une machine : un

super calculateur, comme Mare Nostrum, situé à Barcelone dans une

vielle chapelle. Ce calculateur peut effectuer 42x1012 (soit 42

mille milliards !) opérations par seconde. Les scientifiques ont

ainsi pour ambition de reproduire de manière virtuelle

l’évolution de l´Univers par le biais de la simulation numérique.

Le

Projet Horizon, auquel l’IAP participe activement, est une

initiative visant à fédérer le travail de différentes équipes de

simulations cosmologiques en France afin d’obtenir du temps de

calcul sur les plus grands super calculateurs européens. Pour faire

ces calculs, il faut développer un logiciel spécifique.

RAMSES est un code à

maillage adaptatif en grille cartésienne développé par Romain

Teyssier (CEA Saclay), chercheur associé à l’IAP. Ce programme a la

capacité de se raffiner, c´est-à-dire, de se subdiviser à nouveau

dans les régions denses pour accroître la résolution spatiale et

donc la précision du calcul. Seules trois ou quatre équipes au monde

font de l´hydrodynamique à maillage adaptatif en cosmologie. Ce qui

fait la spécificité de

RAMSES est son bon comportement linéaire en

charge : il fonctionne bien sur des ordinateurs ayant un nombre

élevé de processeurs, comme les 2048 processeurs du super

calculateur Mare Nostrum.

Le Projet Horizon s´est ainsi associé avec une équipe espagnole,

dirigée par Gustavo Yepes (UAM), qui utilise un code hydrodynamique différent

(GADGET)

reposant sur le principe d’une simulation Lagrangienne dite SPH (Smoothed Particle Hydrodynamics)

ou chaque particule est accompagnée d'un petit nuage de taille

variable.

L´objectif est de voir comment les deux grandes simulations

cosmologiques évoluent en partant des mêmes données initiales de

façon à pouvoir identifier les différences qui relèvent des

artefacts numériques d’un code ou de l’autre. Ce projet global,

Projet Mare Nostrum de Formation des Galaxies, est coordonné par

Gustavo Yepes, qui a également fourni les données initiales des

simulations.

Quels sont les éléments qui doivent entrer dans une simulation

cosmologique à grande échelle ? Il faut décrire correctement la

formation des galaxies, la formation des étoiles, l´éjection du vent

stellaire, la présence des différentes espèces chimiques, entre

autres…

RAMSES est l’un des premiers codes numériques qui permette

de prendre en compte ces différents ingrédients physiques. Il offre

également une boîte de simulation (c’est-à-dire le cube d’Univers

reproduit) et une résolution suffisamment grandes pour que

l´échantillon statistique soit significatif.

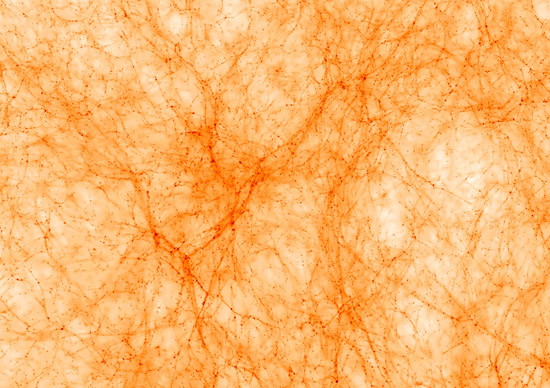

L´image obtenue après une semaine de simulation montre une vision de

l´Univers quand il avait un dixième de son âge actuel. L’époque de

cet Univers simulé correspond aux objets que l’on voit aujourd’hui

avec un décalage spectral (redshift en anglais) de 4, ce que l’on

note également sous la forme z=4. Ce qui est nouveau, grâce aux

caractéristiques de

RAMSES, c’est d´avoir accès dans la même

simulation, à la fois à la formation à grande échelle des structures

de l’Univers et à beaucoup de détails à petite échelle.

Une fois la simulation obtenue, il est possible de mesurer

différents paramètres physiques et de construire d’autres grandeurs

observables. Ainsi il y a 19 millions de macro étoiles dans cette

simulation à z=4. Pour chacune d’elle, on connaît son âge et sa métallicité, aussi on peut reproduire son spectre d’émission. En

assemblant ces étoiles pour constituer des galaxies, il devient

alors possible de comparer les résultats des simulations à des

données observées.

On peut également comparer les résultats de la simulation aux

relevés spectroscopiques de la métallicité des nuages absorbants du

milieu intergalactique, ces amas gazeux situés entre la source de

lumière et notre télescope. Lorsque la lumière émise par une source

puissante, telle qu’un quasar, traverse ce milieu, son spectre est

atténué à certaines longueurs d’ondes représentatives des éléments

absorbants ; la forme des raies d´absorption fournissent des

informations sur les propriétés du milieu traversé : température,

densité de l’élément et décalage spectral du nuage en particulier.

Parce que le spectre d’un objet est très facilement affecté par la

présence de matière sur la ligne de visée, cette technique offre une

sonde particulièrement efficace de la distribution du gaz

intergalactique.

Mais il ne faut jamais oublier que la simulation a ses propres

limites. Cette boîte, de 50 mégaparsecs (Mpa) de côté (soit 150

millions d´années-lumière) reste une assez bonne représentation à

z=4. En revanche, plus le temps passera, moins elle sera

représentative de l´Univers dans sa totalité. Par exemple, elle ne

permet pas de voir les fluctuations de grande densité qui seraient

générées par un objet extrêmement massif, ou des objets à très

petite échelle spatiale en raison du manque de résolution. Il faudra

analyser puis prendre en compte ces différents biais de méthodes,

qui proviennent des différences entre les tailles des échantillons

considérés pour effectuer une comparaison avec les observations.

Inversement, il faudra prendre en compte les biais observationnels

quand nous construirons des pseudo observables à partir des données

de la simulation.

La simulation est supposée fonctionner jusqu´à z=1, ce qui

correspond déjà à la moitié de l´âge de l´Univers et pour lequel il

existe beaucoup d´observations réelles. Chaque avancée d’une unité

de décalage spectral demande cependant plus de temps que la somme

des étapes précédentes car la simulation se raffine au fur et à

mesure pour suivre les effets d’effondrement gravitationnel. Par

ailleurs, il est impossible à l’heure actuelle d’obtenir 3 millions

d´heures sur un super calculateur pour finir cette simulation.. Il

sera donc nécessaire de diminuer la taille de l’échantillon à partir

d’un certain stade pour se focaliser sur certains objets et les

décrire de manière raffinée. Le plus intéressant sera de considérer

des objets semblables à notre Voie Lactée, et de les faire évoluer

jusqu´à z=0. Le reste de la simulation devra alors être décrit à

plus faible résolution. A ce décalage spectral, il deviendra

possible de comparer les résultats de la simulation à ceux des

grands relevés de galaxies, comme le

VIMOS

VLT Deep Survey (VVDS) en particulier.

L'image ici présentée représente, en projection, une portion de l'Univers simulé par

Mare Nostrum/HORIZON, soit un rectangle d'environ 50 millions

d'années lumière par 30, à une époque ou l'Univers était âgé

d'environ 1,5 milliards d'années (un dixième de son âge actuel).

Une version à haute résolution (1

Mo) est disponible en cliquant sur l'image (© Projet HORIZON/Mare Nostrum 2007). |